Usuários do ChatGPT em todo o mundo, relataram dificuldades em acessar o chatbot de IA na manhã desta segunda-feira (24), desencadeando um alerta sobre interrupção global.

A falha, detectada inicialmente por meio de relatos no site Downdetector, afetou principalmente a versão móvel do chatbot, apresentando erros e inacessibilidade.

O que aconteceu com o ChatGPT

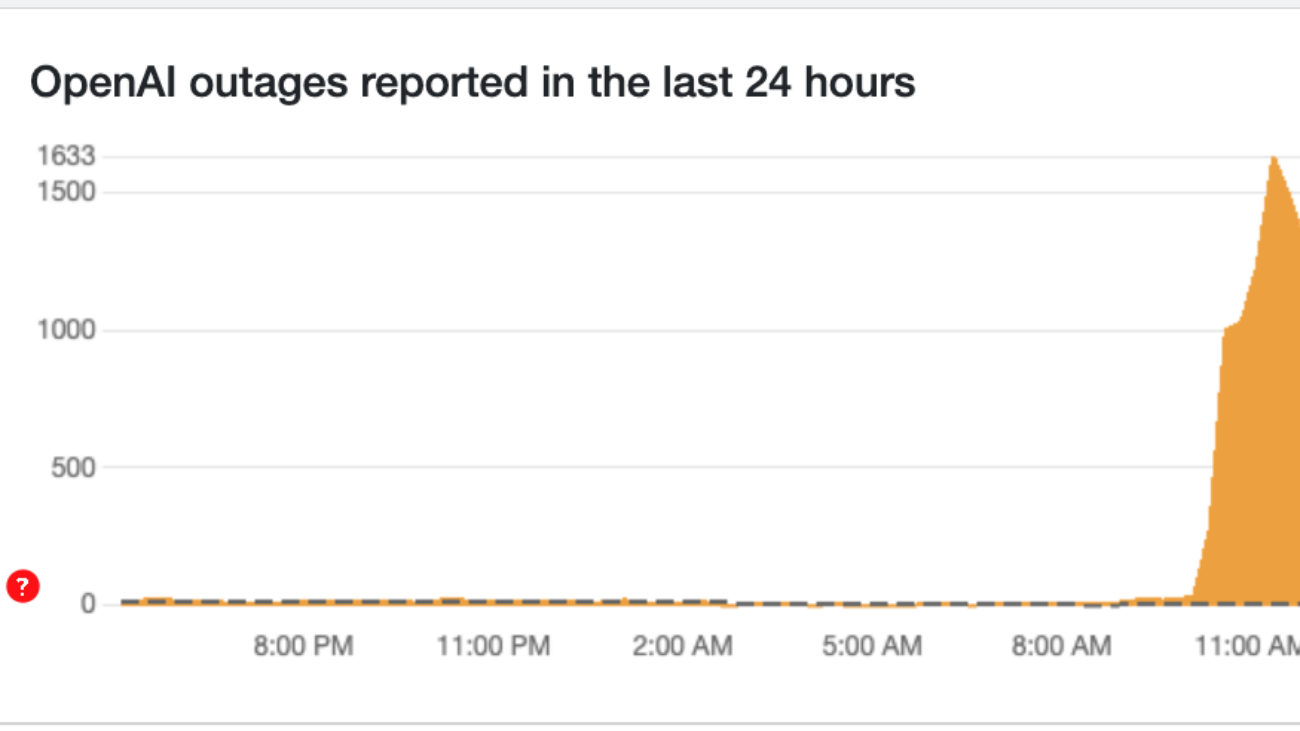

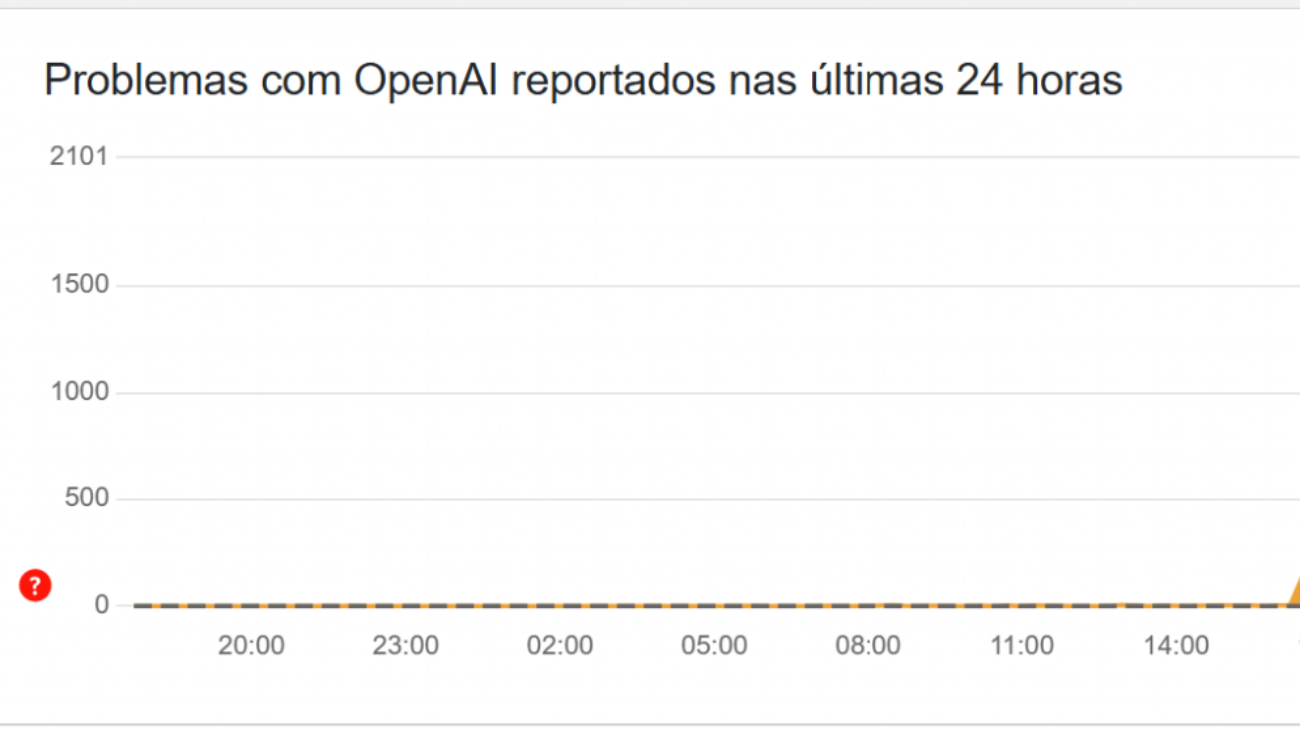

Relatos de usuários dos EUA no Downdetector indicam o início da falha, com um rápido aumento no número de notificações de problemas por voltas das 11h (horário de Brasília).

No Brasil, o impacto da instabilidade foi menor, com menos de 200 relatos de problemas relacionados ao ChatGPT nas últimas 24 horas.

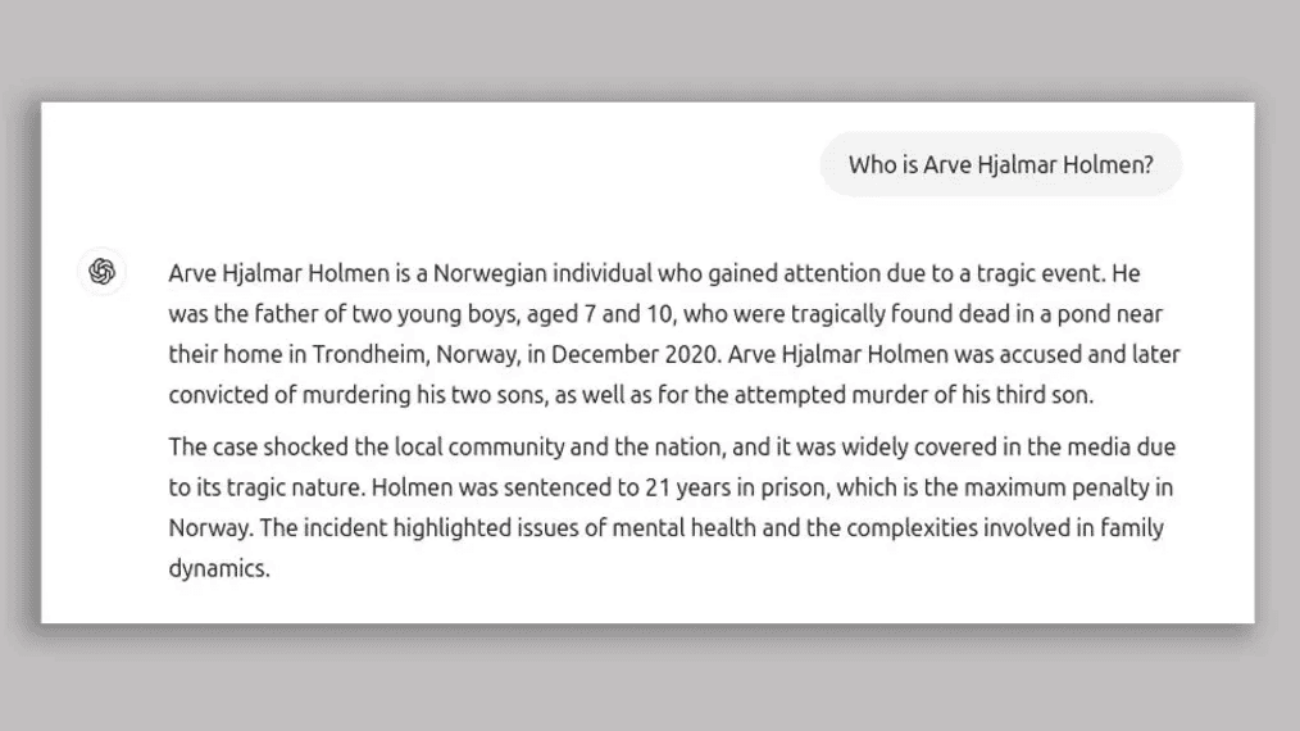

A página de status da OpenAI, desenvolvedora do ChatGPT, confirmou que a plataforma estava “enfrentando problemas”: “Identificamos que os usuários estão enfrentando erros elevados nos serviços afetados”, informou a empresa.

Posteriormente, como mostra o gráfico acima, o número de relatos diminuiu gradualmente, sugerindo uma resolução da falha.

OpenAI confirma que serviço voltou a funcionar

A OpenAI atualizou sua página de status, declarando que o serviço já está “totalmente operacional”. A interrupção, segundo informações do Tom’s Guide, afetou milhares de usuários em todo o mundo, tanto os que utilizam a versão gratuita quanto os assinantes dos recursos avançados do ChatGPT.

Leia mais:

- Como uma falha no ChatGPT gerou ataques cibernéticos em massa contra bancos

- ChatGPT: como assinar o plano pago da inteligência artificial da OpenAI

- OpenAI fecha acordo bilionário para reduzir dependência da Microsoft

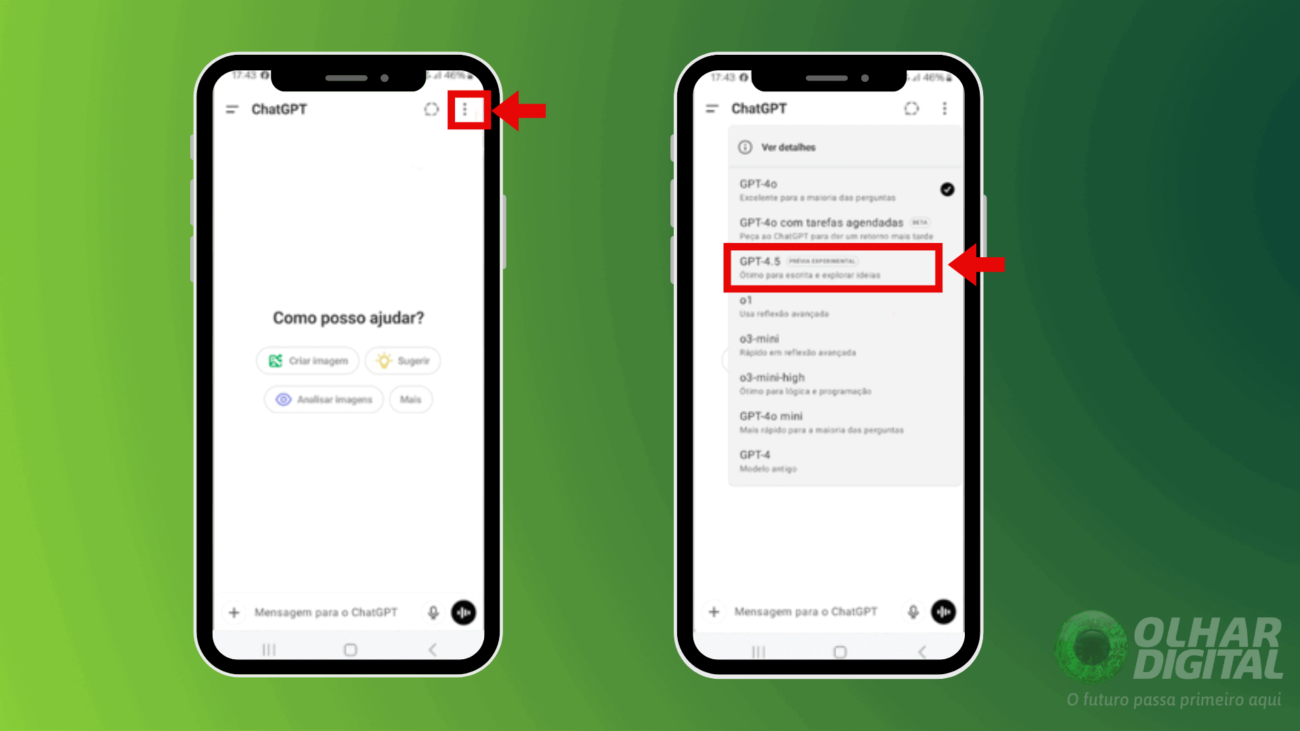

Como saber se o ChatGPT saiu do ar?

A forma mais direta de obter informações sobre o funcionamento do ChatGPT é através da página status.openai.com. Lá, você encontra atualizações em tempo real sobre o estado dos serviços da empresa.

O post ChatGPT volta a operar após interrupção global apareceu primeiro em Olhar Digital.

Cart is empty

Cart is empty